Este post resume las principales ideas que baobab presentó durante el primer Gurobi Industry Day dedicado a las empresas telco.

Cuando me pidieron que hiciera una ponencia sobre la aplicación de la analítica prescriptiva al sector de las telecomunicaciones, pensé que debía partir de su esencia misma para, a partir de ahí, discutir si la evolución prevista de los servicios y redes de telecomunicaciones hará más o menos aplicables este tipo de tecnologías.

La analítica prescriptiva u optimización matemática tiene siempre que ver con la toma de decisiones óptimas. Su concurso es necesario cuando tenemos que ir más allá de las puras predicciones que generan las técnicas basadas en machine learning, y ayudar a seleccionar las mejores opciones en decisiones de negocio que son clave para una empresa (esas en las que nos jugamos la cuenta de resultados).

La optimización en la toma de decisiones está siempre relacionada con un recurso escaso. En otras palabras, algo sólo es relevante para un negocio si tenemos que pensar bien qué uso darle a ese recurso, nada es realmente un componente clave si hay plena disponibilidad de él. En cada escenario el recurso clave será uno u otro (equipos, recursos humanos, presupuesto, espacio en un almacén, tiempo para entregar un producto o servicio…) pero nosotros tenemos claro en cuál queremos poner el foco aquí.

La red es el recurso clave de una empresa de telecomunicaciones

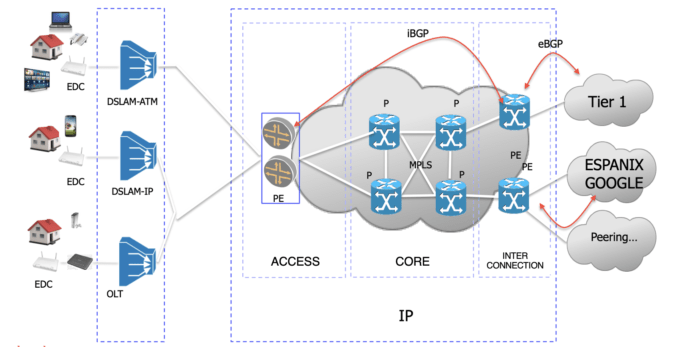

En lugar de detallar todos los recursos escasos que una empresa de telecomunicaciones necesita para hacer negocio, y el tipo de decisiones que serían buenas candidatas para aplicar optimización, vamos a centrar este artículo en el activo clave para una empresa de telecomunicaciones: su propia red. Y siguiendo este enfoque, parece un punto de partida sensato (y una excusa perfecta) incluir una imagen de mis clases de diseño de redes en la universidad. En la figura aparecen algunos de los protocolos y tecnologías clave de los diseños de red del estado del arte.

En esas clases enseñamos a nuestros alumnos BGP, el protocolo que rige la relación entre redes (ASs, Autonomous Systems, si seguimos la forma común de designar los diferentes dominios administrativos dentro de Internet). Mediante BGP, un AS descubre los destinos de red disponibles, ofrece los suyos a los demás y selecciona las mejores opciones en función de criterios de negocio. En definitiva, BGP determina la demanda de red y los flujos interdominio a los que tendrá que hacer frente nuestra infraestructura.

En la figura también se representa un paradigma topológico: la Arquitectura Jerárquica. Los routers dentro de la red core IP se despliegan en diferentes capas y se establecen interconexiones para evitar puntos únicos de fallo dentro de esa arquitectura.

MPLS es el tercer ingrediente al que quiero prestar atención. Es un protocolo que facilita que podamos hacer ingeniería de tráfico. Con MPLS se pueden distribuir los flujos sin seguir ciegamente los caminos más cortos, o incluso dividir un flujo en dos caminos para hacer un uso más eficiente de la infraestructura.

En esas clases también enseñamos a los alumnos cómo se debe redirigir el tráfico en caso de fallos; y, muy relacionado con eso, cómo calcular la capacidad necesaria para cada conexión considerando los eventuales fallos y el redireccionamiento correspondiente de los flujos afectados.

El punto clave es si el diseño y la planificación de la red es o no un buen escenario para la optimización. En primera instancia parecería que sí, que hay espacio para que las matemáticas mejoren estos procesos. Y, simplemente revisando el estado del arte, las redes suelen ser un campo típico para algoritmos de optimización bien conocidos. Por poner algunos ejemplos, consideremos estos dos problemas de optimización (tomados de Eiji Oki, “Linear Programming and Algorithms for Communication Networks”):

- El problema de flujo máximo, que calcula el mayor flujo que puede pasar por una red, dados un par de nodos origen y destino.

- El problema del flujo de coste mínimo, que busca la ruta más corta que es capaz de soportar un flujo determinado.

Sin embargo, tras charlar con algunos amigos que trabajan en empresas de telecomunicaciones en España, la conclusión a la que llego es que no están sacando todo el partido posible a las tecnologías de optimización (y deberían hacerlo).

La razón que esgrimen es que las redes de acceso requieren mucha más inversión que la red core IP, y no quieren arriesgar. Por eso, su principal receta para diseñar ese core IP es sobredimensionar su capacidad; hacen cálculos sencillos -similares a los que realizan nuestros alumnos en clase-, basados en el tráfico medio y pico de cada flujo, para desplegar una capacidad muy por encima de la necesaria con idea de estar preparados para situaciones extraordinarias (el tipo de receta que resultó claramente acertada durante la pandemia para absorber el rápido e inesperado aumento de demanda).

Lo que me gustaría discutir en este artículo es si esta receta puede ser solución estable para las redes de nueva generación. Intentaremos argumentar en contra de esta afirmación, y apostar por la idea de que la optimización y las futuras redes de telecomunicaciones alinearán sus caminos en el corto plazo.

El 5G es una gran promesa

Definitivamente, el futuro de las redes de telecomunicaciones está trazado en los estándares 5G, pero el salto que marcan esos estándares es tan grande que ese futuro se va a ir haciendo realidad poco a poco. Sólo revisando lo esencial de estos estándares es posible llegar a algunas conclusiones del futuro que se perfila, pero os invito a profundizar en los principales argumentos echando un vistazo al magnífico “5G Verticals” de Rath Vannithamby & Anthony Soong.

En primer lugar hay que decir que 5G es, básicamente, una gran promesa: lo llamo gran promesa porque es bastante obvio que las expectativas depositadas en esa evolución son extraordinariamente altas: más cobertura, enormes velocidades, latencias extremadamente bajas…

Al mismo tiempo, es bien sabido que el 5G es la primera generación de servicios móviles que no está estrictamente relacionada con la innovación en la forma de la señal radio. Por supuesto, hay nuevas propuestas para la parte inalámbrica de las redes: la densificación ya no es la principal solución para mejorar la capacidad (en otras palabras, el concepto mismo de celda empieza a desvanecerse), y se prescribe claramente la multiconectividad, la capacidad de satisfacer la demanda de un dispositivo agregando capacidad de diferentes conexiones de radio, incluso desde diferentes estaciones base.

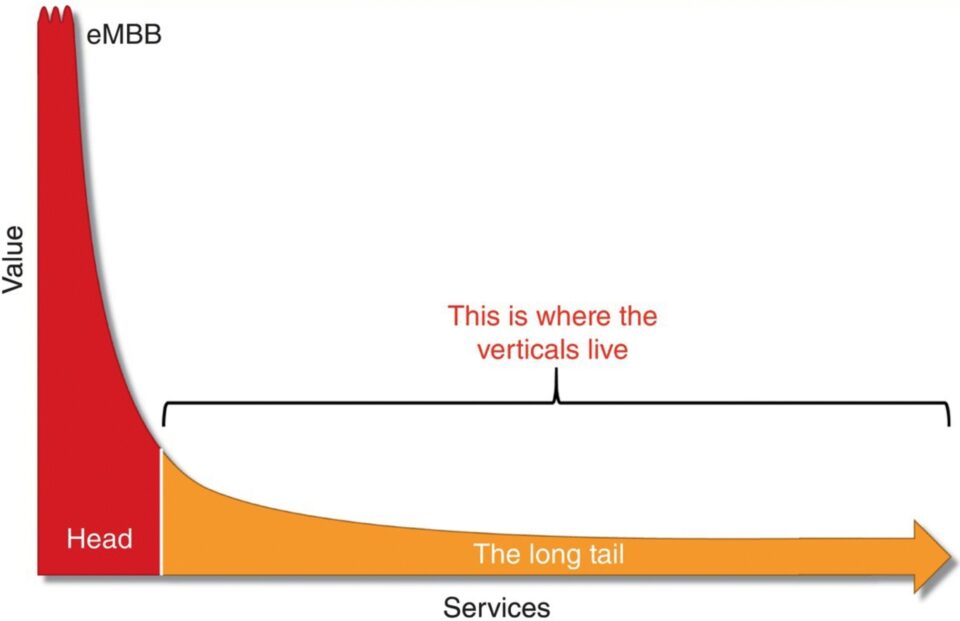

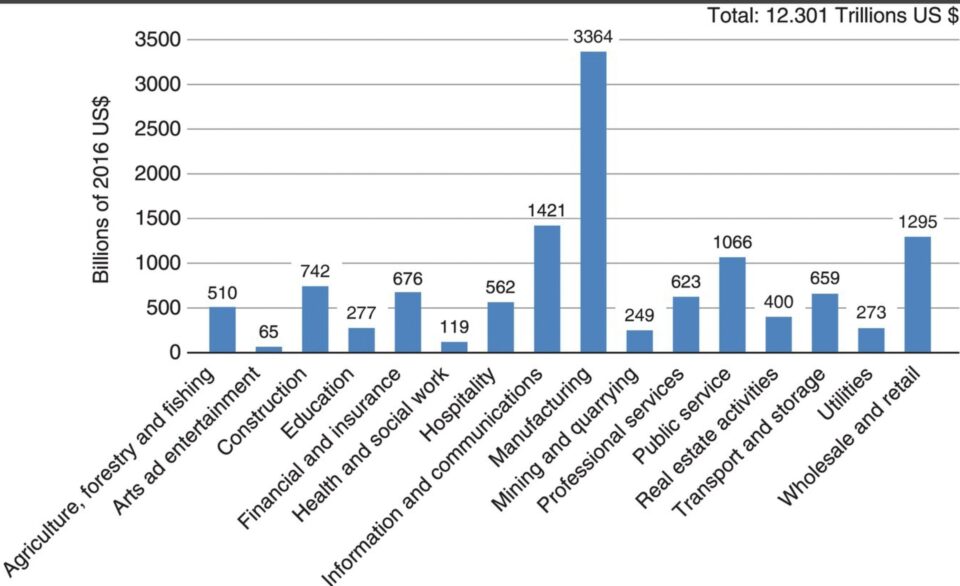

Pero, en mi opinión, la dirección más innovadora que marca 5G es que se avecina una enorme cantidad de nuevos usuarios que van a unirse a la red para disfrutar de sus servicios; y esos usuarios van a ser máquinas. Además, teniendo en cuenta que estamos bastante cerca de alcanzar el ratio de un dispositivo móvil por habitante a nivel global, estos nuevos usuarios no humanos deben ser la mejor estrategia de crecimiento para las empresas de telecomunicaciones. En otras palabras, el servicio eMBB (enhanced mobile broadband), nombre estándar del servicio de banda ancha para humanos, va a ser masivo; pero 5G anticipa una larga cola de tamaño enorme para nuevos negocios basados en verticales específicos (e.g. la fabricación, que será un vertical clave al que le espera un futuro revolucionario si se analizan todas las expectativas levantadas por el concepto Industria 4.0).

Repasando algunas de las principales tendencias técnicas que servirán de base para hacer realidad los estándares 5G, queda bastante claro que, a grandes rasgos, se trata de tecnologías que tratan de aportar flexibilidad al diseño y la configuración de las redes.

- NFV son las siglas de Network Function Virtualization. Es decir, la capacidad de desacoplar las funciones de red de la infraestructura física de la red. Es la tecnología que nos permitirá desplegar funciones de red en hardware genérico y hacer posible el despliegue flexible de diferentes arquitecturas de red, en función de las necesidades y sobre la misma infraestructura.

- A su vez, la tecnología SDN (Software Defined Networks) pretende desacoplar los planos de datos y de control, haciendo posible redes programables. Es decir, se trata de la capacidad de alterar el funcionamiento del plano de control mediante software que se despliega a voluntad en el dispositivo, algo factible porque la relación con el plano de datos que gestiona la redirección de los paquetes está bien estandarizada a través de APIs. O sea, será posible modificar el comportamiento de la red con sólo configurar los dispositivos mediante software.

Pero la propuesta más impresionante y exigente es network slicing. Una porción (slice) de red es una red lógica que proporciona capacidades específicas de interconexión (con una calidad de servicio bien definida) a un solo cliente. El requisito clave es el aislamiento, cualquier porción o slice no puede verse afectado por condiciones extremas en otros, aunque, de hecho, comparten la misma infraestructura. La necesidad de una orquestación avanzada es muy evidente: tenemos que asignar recursos en una infraestructura profundamente configurable para satisfacer necesidades muy diversas y complejas, sujetas a condiciones que son dinámicas. ¿No empieza a sonarnos ya a un campo proclive a la optimización matemática?

Conclusiones: las redes futuras necesitarán optimización

Si pensamos en los tres ingredientes principales de un buen escenario de optimización (un recurso escaso, un entorno complejo en el que hay que tomar una decisión, y una decisión de negocio con un gran impacto real), es bastante obvio que 5G es una especie de cóctel de optimización perfecto para el sector que podemos resumir así:

- El aumento de la complejidad se debe a los nuevos servicios, con requisitos muy exigentes, que deben ser soportados por una infraestructura común que tendrá mucha más flexibilidad para configurarse de una u otra forma.

- La escasez se debe a la demanda masiva de ancho de banda que anticipan los nuevos usuarios en diferentes verticales.

- El impacto en el negocio futuro es obvio, el crecimiento de la mayoría de las empresas de telecomunicaciones dependerá de esos nuevos verticales que se incorporen a nuestras redes.

Para resumir, me gustaría esbozar algunas conclusiones finales:

- En cuanto a las redes de telecomunicaciones, habrá más decisiones, más complejas y con mayor impacto en los KPIs en el futuro que se anticipa con la llegada de los estándares 5G.

- Si necesitamos ofrecer nuevos servicios a verticales específicos (la larga cola), la capacidad de controlar la infraestructura común será clave para ganar competitividad reduciendo el tiempo de comercialización de estos nuevos servicios.

- Algunas de las recetas actuales para el diseño y el control de la red van a perder eficacia: ¿Bastará con dejar que los proveedores de equipos desarrollen soluciones genéricas de optimización/orquestación? ¿Será el sobredimensionamiento de la capacidad la principal estrategia para satisfacer las demandas de los usuarios en una red como esta? Mi apuesta es que esas recetas ya no serán soluciones viables. Las redes de telecomunicaciones y las tecnologías de optimización están condenadas a entenderse.